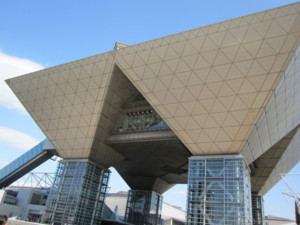

ちょいとクラウド周りの情報収集のために東京ビッグサイトまで出かけてきた。その雑感をメモ。

「クラウド」って?

まぁー、正直、百花繚乱というか、クラウドに関係がありそうなソリューションが自己申告で展示会に出てきてる印象。従来であれば、ASPという括りだったんじゃないのかと思えるようなアプリケーションベンダー(例えば、グループウェアとか)と、仮想化されたサーバを提供するようなキャリア(ま、ホワイト何とかの人たち)が同じ会場で、「ウチのクラウドが…」と語り始めるのは違和感がある。ITギョーカイとして、「クラウド」って言葉の定義というか、これまでの既存の概念と何が違うのかというあたりがさっぱり整理されていないなぁというか…。

レンタルサーバでいいじゃん。

個人的に、ハードウェアの仮想化に興味があったので、上記のアプリケーションベンダーの皆さんの話は割愛(…けど、雰囲気的には、アプリケーションベンダーの数がやっぱり多かったんだけど)で、いわゆる、HaaSといわれているようなサービスを提供するベンダーに話を聞いてみた。まぁ、なんつーか、XenやVMwareとか、簡単に仮想化できるミドルウェアが増えてきたから、(データセンターの利用効率を上げたい)通信キャリアのみなさんが自社のデータセンターに片っ端からサーバ詰めて、仮想化ミドルをインストールしてみただけなんじゃないのかっていう…、そんな印象。むしろ、安いHaaSだといろんなものがシェアされてるので、リソースの割り当て状況とか、微妙に気になるなぁ。例えば、誰かが24時間ずっと重いバッチが走らせているようなVMを動かしているとして、そのVMと同じ物理サーバには同居したくないなぁとか。

シェアリングすると言ってもね。

そういえば、安いHaaSだと、結構、いろんなものをシェアしてることがわかった。例えば、某HaaSはオプションでロードバランサを提供しているみたいなんだけど、ロードバランサ用にVMのインスタンスを立てて、keepalivedいれて…というものではなくて、ネットワークのどこかに置かれたアプライアンスのロードバランサをシェアするというサービスらしい。クソ高い、アプライアンスなロードバランサを安価で使えるというメリットはあるのかもしれないが、例えば、自分以外のお客さんのトラフィック急増でロードバランサが過負荷に陥っても、まぁ、ベストエフォートですからねぇと、生ぬるい笑みを浮かべるしかないと思うと、ちょっと切ない。

スペック感がよくわからん。

まー、どこでもそうなんですが、HaaSって、スペックに「CPU:1コア」とか「HDD:30GB」とかさらりと書かれている。これがまた結構ややこしい。同じCPUの1コアでも、例えば、CeleronとXeonでは計算能力がわりと違ってたりするだろうし、同じXeonでも古いのと新しいのではスペックが違うしなぁ。ディスクにしても、RAID5で構成されたRAID Arrayの上の30GBと、SSDの30GBではいろいろと違うんじゃないかという…。まぁ、運用していって、もし、能力が足りなくなってきたら、追加インスタンス起動っていうシンプルなルールでスケールアウトしていきゃいいんだろうけど、事前に見積もりして、いわゆるHaaSの方が安そうだって結論は得ておきたい。そうなると、なんかもうちょっと詳細なスペックが提示できないもんだろうか。

で、本当にメリットあるのか。

まぁ、HaaSとかはじめちゃうベンダーさんは、品質のいいデータセンターに、割と高いサーバを並べてるから、この値段なんですと言われると、そうなんだろうけれど、例えば、Webアプリ屋さんがVMをずらーっと並べてスケールアウトしたときに、本当に物理サーバを抱えていくよりメリットが出てくるんだろうかという気がした。例えば、コスト面でのメリット。最近のWeb系アプリをやってる人たちは自作でサーバを作れたりするし、自前でロードバランサもなんとかできちゃったりする。そういう人たちがハードウェアを所有するコストは、意外と安かったりするんじゃないだろうか。そういう人たちがHaaSに移行するメリットって何かあるんだろうか(遠い目)

うーむ、眠くなってきたので、とりあえず、こんな感じで。

日経BP出版センター

売り上げランキング: 2026

流行に強い日経

流行に強い日経